High Performance Computing Center – HPCC

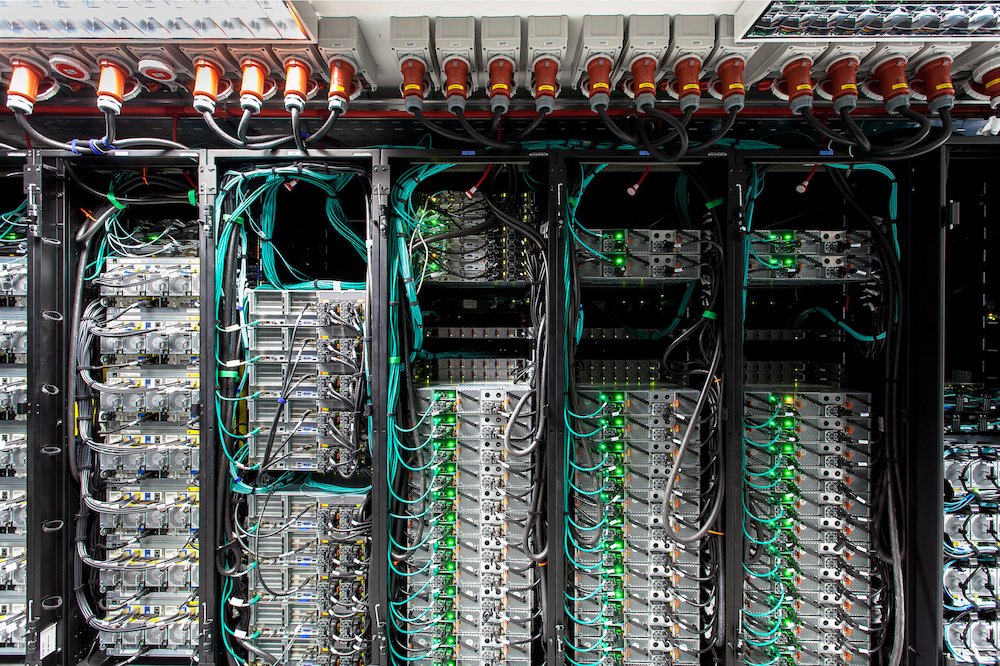

Il Centro HPCC del CMCC a Lecce, attivo dal 2008 è la più grande struttura di calcolo in Italia – e tra le più avanzate in Europa – dedicata esclusivamente alla ricerca sui cambiamenti climatici e alle loro interazioni con la società e i sistemi economici.

Il Centro di calcolo è stato potenziato nel 2022 sia per quello che riguarda la struttura di calcolo che i sistemi di archiviazione.

32,400

cores

2,359

TFlops

Theoretical peak performance (1TFlop = 1,000 billion operations per second)

37

PetaBytes

Disk Storage capacity

62

PetaBytes

Tape Library (archiving system)

Il Centro di calcolo ad alte prestazioni del CMCC è composto da due strutture di calcolo che interagiscono tra loro.

CASSANDRA

Cassandra è composta da 180 nodi di elaborazione Lenovo SD650 V3, ciascuno dotato di doppi processori Intel Xeon Max 9480 con 56 core ciascuno, per un totale complessivo di 20.160 core. Questa configurazione, supportata dalla nuova famiglia di processori Intel Sapphire Rapids HBM, consente a Cassandra di raggiungere un’eccezionale potenza di calcolo di 1.225 TFlops. Inoltre, per garantire l’efficace conservazione e accessibilità di grandi quantità di dati climatici generati dalle attività di ricerca del CMCC, l’HPCC incorpora il Deep Archive Storage System (DASS), che offre una capacità di 62 Petabyte con 20 unità nastro LTO8.

JUNO

Juno ha una potenza di calcolo di circa 1.134 TFlops e si basa sui processori Intel Xeon Scalable di terza generazione (nome in codice “Ice Lake”) e anche sulla GPU NVIDIA A100 (architettura NVIDIA Ampere). Il progetto di potenziamento delle strutture di calcolo e archiviazione è stato realizzato nel 2021-22 attraverso i fondi europei dedicati al Programma Operativo Regionale 2014-2020 (Regione Puglia).

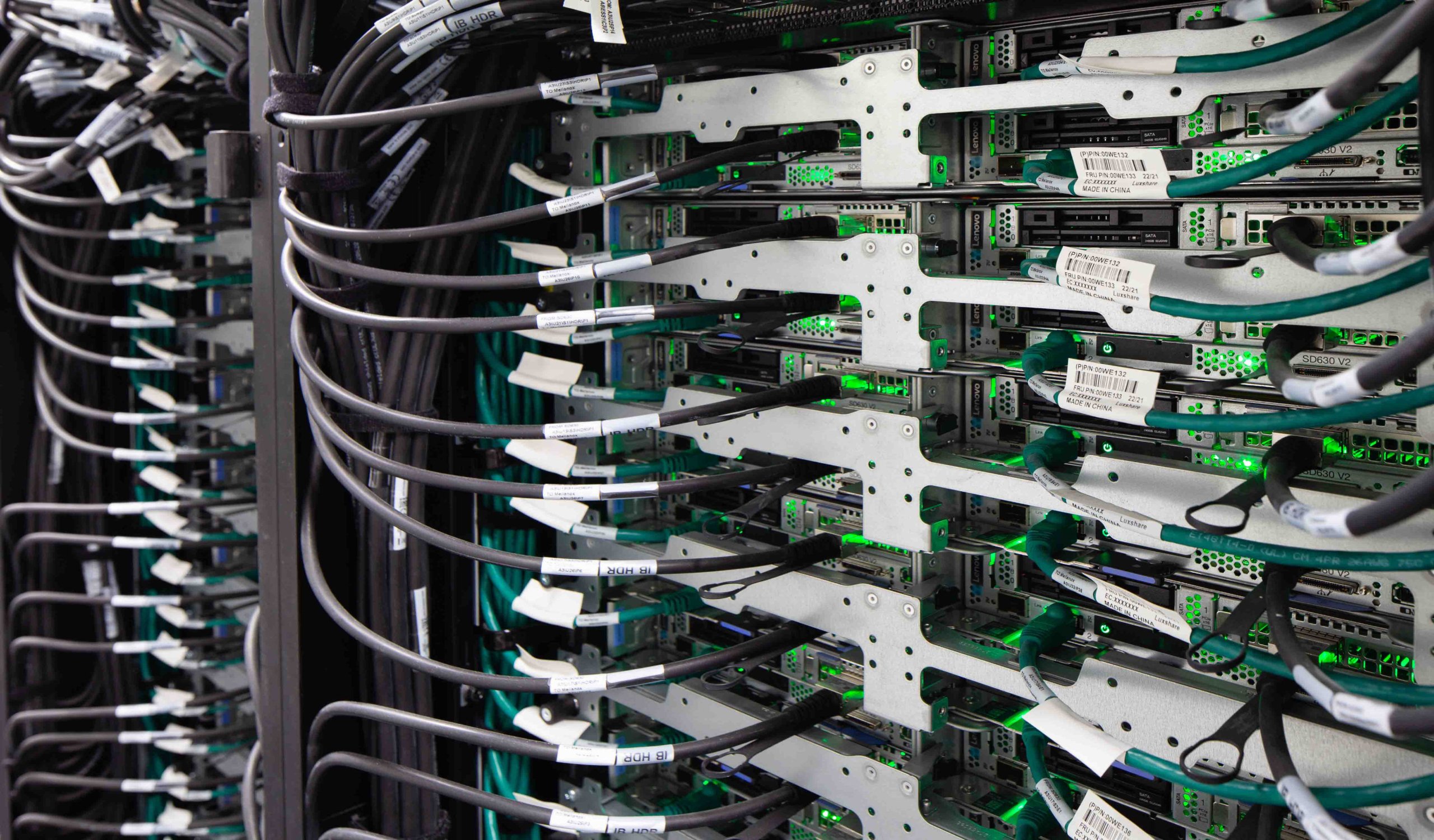

JUNO

Compute node type: Lenovo SD630 v2

Processor type: Intel Xeon Platinum 8360Y (36 cores)

Processor Speed: 2.4 GHz

# of processor cores: 12,240

GPU type: NVIDIA A100

# GPU: 20

# of nodes: 170 (dual processors nodes)

Memory per node: 512 GB

Interconnection: Infiniband HDR (200Gbps)

Peak Performance: 1,134 TFlops

Operating System: Red Hat v.8.4 (Linux x86_64)

Batch Queueing System: IBM Spectrum LSF v.10.2 (HPC Suite)

Cluster Parallel File System: IBM Spectrum Scale v.5.1 (GPFS)

File systems:

- /users_home: 100TB

- /work: 11.3 PB of usable capacity

- /data: 11.7 PB of usable capacity

CASSANDRA

Compute node type: LENOVO SD650 V3 (Direct Water Cooled)

Processor type: Intel Xeon Max 9480 (56 cores) (Sapphire Rapids HBM)

Processor Speed: 1.9 GHz

# of processor cores: 20,160

# GPU: n.a.

# of nodes: 180 (dual processors nodes)

Memory per node: 1024 GB

Interconnection: Infiniband NDR (400Gbps)

Peak Performance: 1,225 TFlops

Operating System: Red Hat v.9.0 (Linux x86_64)

Batch Queueing System: IBM Spectrum LSF v.10.x (HPC Suite)

Cluster Parallel File System: IBM Spectrum Scale v.5.x (GPFS)

File systems:

- /users_home: 100TB

- /work: 13.6 PB of usable capacity

Al fine di gestire e conservare nel medio e lungo termine l’enorme quantità di dati climatici prodotti dalle attività di ricerca e operative del CMCC, nel 2019 è stato implementato un nuovo sistema di archiviazione dei dati. Trasferito nel 2022 presso la nuova sede del CMCC, anche il sistema di archiviazione è stato aggiornato per estendere sia la sua portata (a 40 PetaByte) che la sua capacità input/output, aggiungendo altre 8 unità LTO8.